Привет, друзья! Наверняка, многие об этом не знают. Даже я не...

Привет, друзья! Наверняка, многие об этом не знают. Даже я не...

774

774

Привет, друзья! Наверняка, многие об этом не знают. Даже я не знал, так как никогда не сталкивался с такой ситуацией, но коллеги поделились интересным случаем.

Google может подхватить старую версию robots.txt и держать ее в кеше. У коллеги так случилось на момент переезда, и сайт для гуглбота оказался закрытым для индексации. Хотя по факту в robots.txt он открыт.

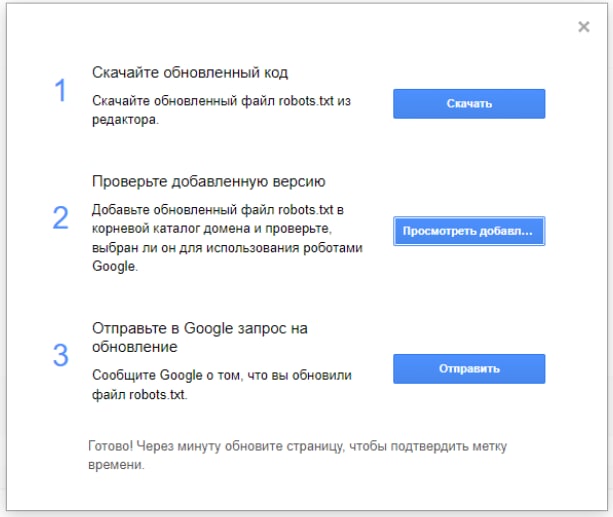

Короче, можно отправлять robots.txt на пересканирование, если вдруг что-то пошло не так:

🔗 Инструмент: https://www.google.com/webmasters/tools/robots-testing-tool?hl=ru

🔗 Справка: https://developers.google.com/search/docs/advanced/robots/submit-updated-robots-txt?hl=ru

Уже через минуту robots.txt обновился, и стало возможным отправлять страницу на переобход в GSC, хотя ранее он ругался, что сайт закрыт для индексации.

PS Жаль, что нельзя добавить кучу скринов, чтобы пошагово показать, как проявлялась проблема и как потом обнаружились причины. Надеюсь, вы разберетесь. В общем, если столкнетесь с тем, что URL есть в индексе Google, все корректно, но вдруг при проверке расширенных результатов увидите «URL недоступен Google» - вы теперь знаете, что делать.

А дополнительные скрины я все же закину в комментарии.

– https://telegra.ph/file/6a0b9a2e31cf14ab3bd91.jpg

Источник новости https://t.me/alaevseo/460...